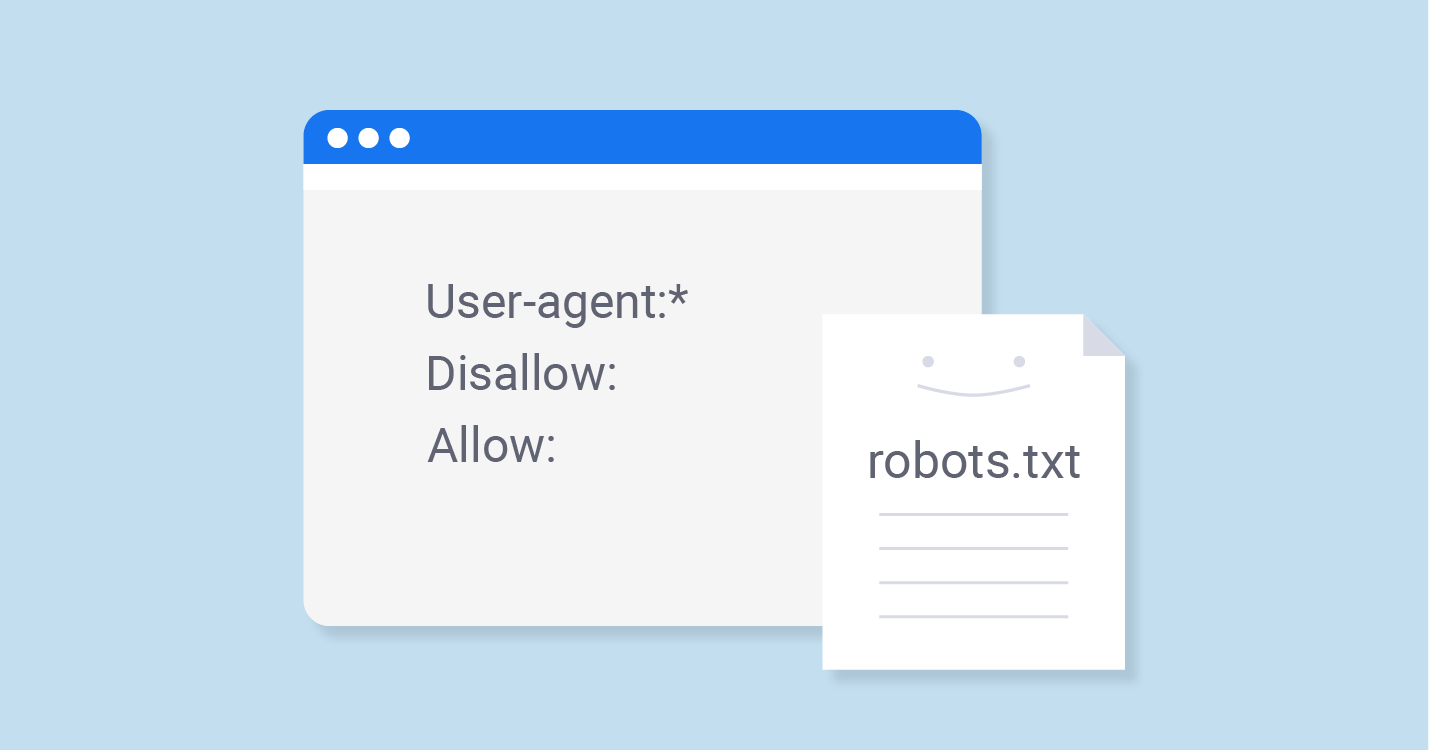

Desgranando el archivo robots.txt

El archivo robots.txt es un fichero que se encuentra en la raíz de un sitio web y sirve para indicar a los robots de los buscadores qué áreas de dicho sitio pueden indexar y cuáles no.

Aunque el robots.txt no es un archivo obligatorio, es recomendable utilizarlo para evitar que los buscadores indexen contenido que no queremos que aparezca en los resultados de búsqueda, como páginas de error, directorios o ficheros innecesarios.

El archivo robots.txt se compone de una serie de líneas de texto (una por cada regla) en las que se especifican los comandos y las URL afectadas por dichos comandos.

Cómo crear el archivo robots.txt

Para crear el archivo robots.txt, lo primero que debemos hacer es acceder a la raíz de nuestro sitio web (por ejemplo, si nuestro sitio se encuentra en la URL www.micasa.com, accederemos a la raíz del sitio mediante la URL www.micasa.com/robots.txt).

Una vez en la raíz del sitio, deberemos crear un archivo de texto en el que incluiremos las reglas que queramos que se apliquen a los robots de los buscadores. El nombre del archivo debe ser “robots.txt” y debe estar en formato de texto plano (es decir, no debe estar en formato de documento Word o de cualquier otro procesador de textos).

¿Qué elementos forman el robots.txt?

Como ya hemos mencionado, el archivo robots.txt se compone de una serie de líneas de texto en las que se especifican los comandos y las URL afectadas por dichos comandos.

Los comandos son un conjunto de instrucciones que indican a los robots de los buscadores qué deben hacer en relación con el contenido de las URL especificadas.

Las URL son las direcciones de las páginas web, directorios o ficheros a los que se aplicarán las instrucciones especificadas en los comandos.

- Comandos

Los comandos se dividen en dos grupos:

Comandos de uso general: estos comandos se aplican a todos los robots de los buscadores que visiten el sitio web.

Comandos específicos: estos comandos se aplican únicamente a los robots de los buscadores especificados.

Los comandos más utilizados en robots.txt son los siguientes:

- User-agent: este comando indica a qué robot de los buscadores se aplica la regla especificada en la línea de texto.

- Allow: este comando indica qué áreas del sitio web pueden ser indexadas por el robot de los buscadores especificado.

- Disallow: este comando indica qué áreas del sitio web no pueden ser indexadas por el robot de los buscadores especificado.

- Sitemap: este comando indica la ubicación del archivo sitemap.xml del sitio web.

- Crawl-delay: este comando indica el número de segundos que debe esperar el robot de los buscadores antes de acceder a la siguiente página del sitio web.

Reglas específicas

Lee Tambien: Temas Relacionados Sitemap XML

Sitemap XMLLas reglas específicas se utilizan para indicar a los robots de los buscadores qué áreas de un sitio web pueden ser indexadas y cuáles no.

Las reglas específicas se componen de un comando y una o más URL. El comando indica qué acción debe realizar el robot de los buscadores en relación con las URL especificadas.

Las URL especificadas en las reglas específicas pueden ser direcciones de páginas web, directorios o ficheros.

¿Cuáles son los comandos más utilizados en robots.txt?

Los comandos más utilizados en robots.txt son los siguientes:

- User-agent: este comando indica a qué robot de los buscadores se aplica la regla especificada en la línea de texto.

- Allow: este comando indica qué áreas del sitio web pueden ser indexadas por el robot de los buscadores especificado.

- Disallow: este comando indica qué áreas del sitio web no pueden ser indexadas por el robot de los buscadores especificado.

- Sitemap: este comando indica la ubicación del archivo sitemap.xml del sitio web.

- Crawl-delay: este comando indica el número de segundos que debe esperar el robot de los buscadores antes de acceder a la siguiente página del sitio web.